2023-02-14 10:24:34 +08:00

公司部门购买了一台群晖 1821+ 当作数据服务器来用,目前塞了 6 块硬盘组了一个 Raid5 存储池。

最近对其中的数据进行整理时发现,移动文件夹时速度巨慢无比,完全刷新了我对群晖 NAS 文件系统的认知。

一般来说,在同磁盘 /存储池中移动文件 /文件夹只是在记录中改变指针地址,理论上来说应该瞬间完成。但是群晖的表现实在是令人费解:速度奇慢,且任务进度条卡在 0%处不再改变,再过~1 小时 /若干小时之后再看,任务完成了。

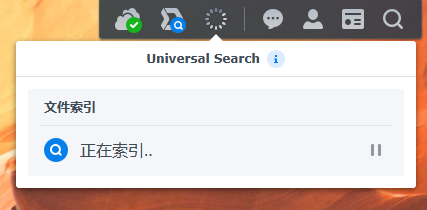

咨询了产品售后,其也不清楚,在与官方技术沟通后告诉我说:群晖的 NAS ,在 File Station 中移动文件时需要重新做索引,速度就是很慢,类似于实际对数据进行了移动;如果想快速移动需要 ssh 登录进 NAS 系统后通过命令操作。

到目前为止,还是很难相信群晖 NAS 系统是这样的操作逻辑。对于企业用户来说,系统中包含数量庞大的数据是很正常的情况,如果对数据整理时采用这种逻辑,大大影响了正常的操作体验。

发现这个现象后开始在网上搜索,并没有发现有人提出类似的问题。不知各位朋友在使用群晖 NAS 时有没有遇到过这种情况?有没有什么更好的解决方案呢?

这是一个专为移动设备优化的页面(即为了让你能够在 Google 搜索结果里秒开这个页面),如果你希望参与 V2EX 社区的讨论,你可以继续到 V2EX 上打开本讨论主题的完整版本。

V2EX 是创意工作者们的社区,是一个分享自己正在做的有趣事物、交流想法,可以遇见新朋友甚至新机会的地方。

V2EX is a community of developers, designers and creative people.