2023-03-20 10:41:50 +08:00

audioFlux 是一个 Python 和 C 实现的库,提供音频领域系统、全面、多维度的特征提取与组合,结合各种深度学习网络模型,进行音频领域的业务研发。音频特征较为全面,支持移动端,提供尽可能细粒度、体系化的特征维。

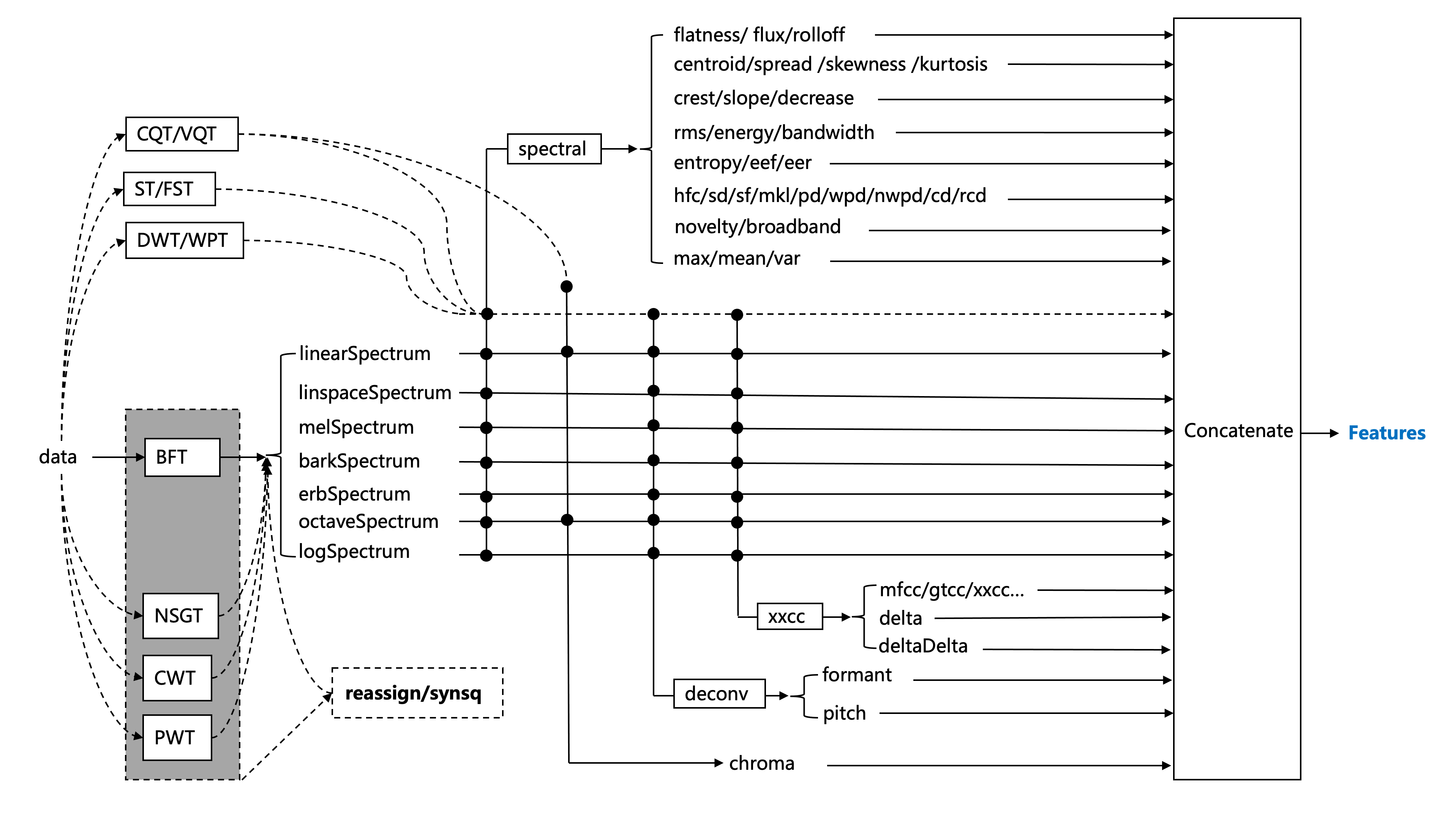

audioFlux 基于数据流设计。它在结构上解耦了每个算法模块,可以快速有效地提取多个维度的特征。以下是主要功能体系结构图。

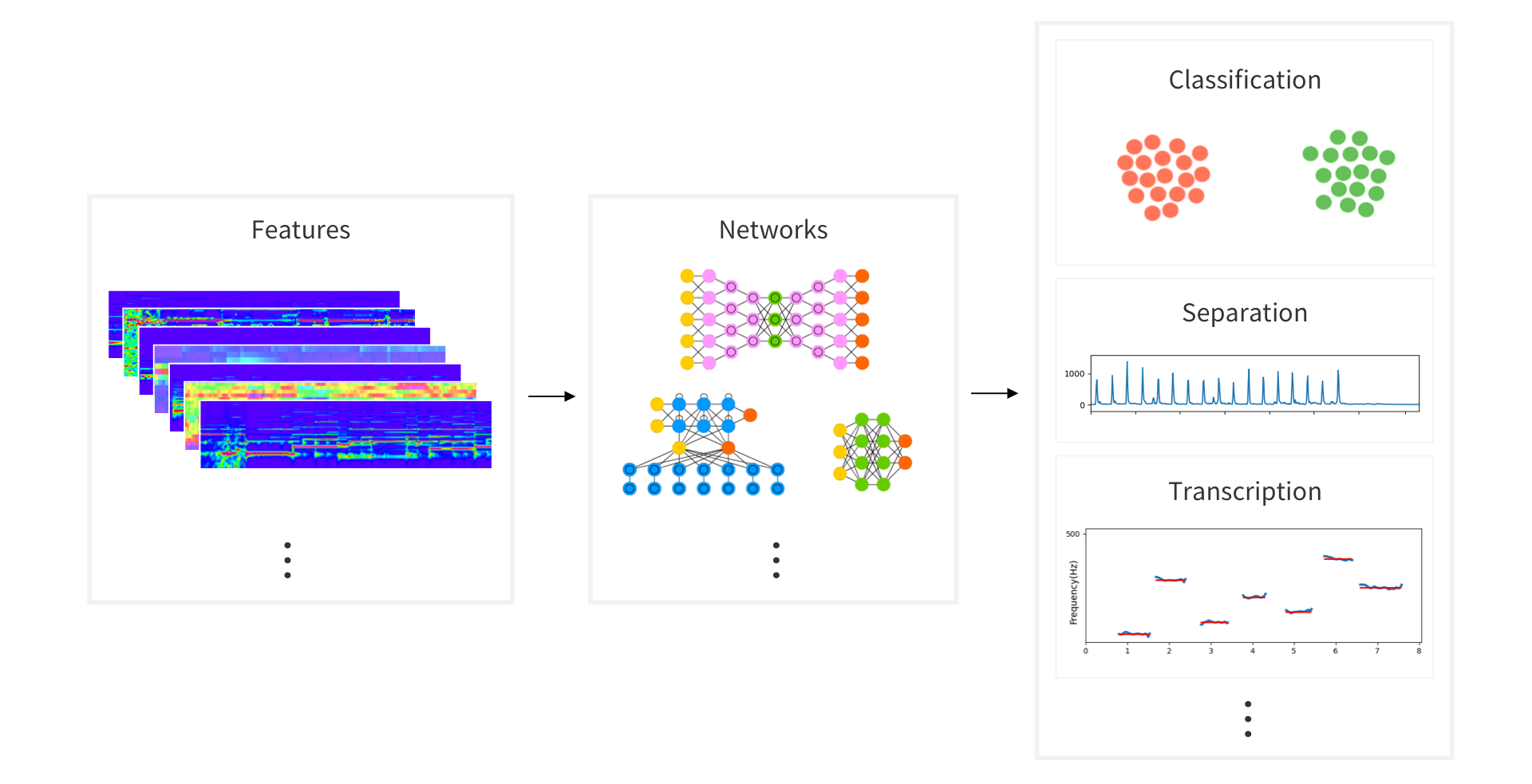

可以使用多维特征组合,选择不同的深度学习网络训练,研究音频领域的各种任务,如 Classification 、Separation 、MIR 等。

pip install audioflux

import numpy as np

import audioflux as af

import matplotlib.pyplot as plt

from audioflux.display import fill_spec

# Get a 220Hz's audio file path

sample_path = af.utils.sample_path('220')

# Read audio data and sample rate

audio_arr, sr = af.read(sample_path)

# Extract mel spectrogram

spec_arr, mel_fre_band_arr = af.mel_spectrogram(audio_arr, num=128, radix2_exp=12, samplate=sr)

spec_arr = np.abs(spec_arr)

# Extract mfcc

mfcc_arr, _ = af.mfcc(audio_arr, cc_num=13, mel_num=128, radix2_exp=12, samplate=sr)

# Display

audio_len = audio_arr.shape[0]

# calculate x/y-coords

x_coords = np.linspace(0, audio_len / sr, spec_arr.shape[1] + 1)

y_coords = np.insert(mel_fre_band_arr, 0, 0)

fig, ax = plt.subplots()

img = fill_spec(spec_arr, axes=ax,

x_coords=x_coords, y_coords=y_coords,

x_axis='time', y_axis='log',

title='Mel Spectrogram')

fig.colorbar(img, ax=ax)

fig, ax = plt.subplots()

img = fill_spec(mfcc_arr, axes=ax,

x_coords=x_coords, x_axis='time',

title='MFCC')

fig.colorbar(img, ax=ax)

plt.show()

Github: https://github.com/libAudioFlux/audioFlux 欢迎探讨关于音频相关的问题

这是一个专为移动设备优化的页面(即为了让你能够在 Google 搜索结果里秒开这个页面),如果你希望参与 V2EX 社区的讨论,你可以继续到 V2EX 上打开本讨论主题的完整版本。

V2EX 是创意工作者们的社区,是一个分享自己正在做的有趣事物、交流想法,可以遇见新朋友甚至新机会的地方。

V2EX is a community of developers, designers and creative people.